참고 논문 :

An overview of gradient descent optimization algorithms

Gradient descent optimization algorithms, while increasingly popular, are often used as black-box optimizers, as practical explanations of their strengths and weaknesses are hard to come by. This article aims to provide the reader with intuitions with rega

arxiv.org

참고 사이트 :

Gradient Descent Variants 정리

딥러닝(Deep learning) 살펴보기 2탄

지난 포스트에 Deep learning 살펴보기 1탄을 통해 딥러닝의 개요와 뉴럴 네트워크, 그리고 Underfitting의 문제점과 해결방법에 관해 알아보았습니다. 그럼 오늘은 이어서 Deep learning에서 학습이 느린

seamless.tistory.com

Gradients Descent Variants 정리

Gradients Descent Optimization Algorithms정리

그래서 어떤 Gradients Descent Optimizer 를 써야 하는가? (2017 기준)

if you care about fast convergence and train a deep or complex neural network, you should choose one of the adaptive learning rate methods.

"빠른 수렴을 원하거나, 복잡한 뉴럴 네트워크에서 훈련하면 적응적 학습율 알고리듬 중 하나를 사용하는 것이 좋다."

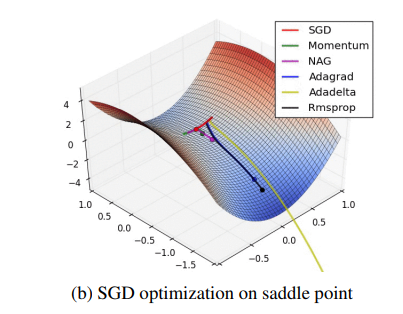

이는 논문에 제시된 saddle point 문제를 해결하는 차이를 나타낸 그림으로 충분히 납득이 된다.

Insofar(2017 기준), Adam might be the best overall choice.

"2017 기준으로 Adam 이 전반적으로 가장 좋은 선택이다."